IT之家6月8日消息 在iOS 13中,苹果终于推出了多摄像头同步开启支持,允许应用程序在iPhone或iPad上同时捕获来自多个麦克风和摄像头的照片、视频、音频,元数据和深度信息。

自从OS X Lion以来,苹果长期一直支持macOS上的多摄像头捕获,但到目前为止,硬件限制使其无法推出适用于iPhone和iPad的API。

iOS 13中的新功能和API将允许开发人员提供同时从前置摄像头和后置摄像头传输视频、照片或音频的应用程序。

iOS 13多摄像头支持w/ AVCapture?

在WWDC19期间推出新功能时,苹果演示了一个画中画视频录制应用,该应用从前置摄像头录制,同时还可以从主摄像头录制。

该演示应用程序还启用了视频录制功能,以及在照片应用播放期间即时交换两个摄像头的功能。该功能还可以让开发人员控制双TrueDepth摄像头,包括后视宽角镜头或后视长焦镜头的单独视频流。

iOS 13支持新的多摄像头功能,仅适用于较新的硬件,包括iPhone XS、iPhone XS Max、iPhone XR和iPad Pro。

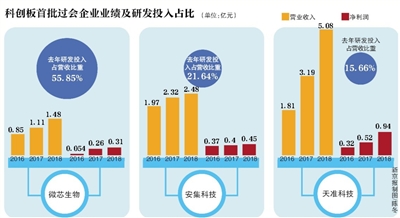

苹果列出了许多支持多摄像头捕获的格式(如上图所示),开发人员会注意到它会对相机的正常功能施加一些人为限制。

由于移动设备的功率限制,与Mac不同,iPhone和iPad将仅限于单个多摄像头会话,这意味着你无法同时在多个应用中开启多个摄像头,或者使用多个摄像头进行多个会话。还将有各种支持的设备组合,指示在某些设备上支持哪些摄像机的捕获组合。

苹果本身并没有在iOS 13相机应用程序中使用任何新的多摄像头功能,但我们认为它现在正在出现,因为它正式在AVCapture中推出了支持。

Semantic Segmentation Mattes(语义分割蒙版)

iOS 13中相机捕捉的新功能还有语义分割蒙版。在iOS 12中,苹果在内部使用了Portrait Effects Matte为人像模式照片设置内容,将主体与背景分开。在iOS 13中,苹果推出了所谓的Semantic Segmentation Mattes来识别皮肤、头发和牙齿,并通过API进一步改进这些信息,供开发人员使用。

在WWDC会议上,苹果展示了新技术的演示应用程序,允许将照片中的主体与背景分离,并将头发、皮肤和牙齿隔离,以轻松添加效果,包括面部涂料和头发颜色变化(如上图)。

开发人员可以在苹果的网站上了解有关多摄像头支持和语义分段的更多信息,它还提供了演示应用程序的示例代码。